WERとは? ワードエラーレートとはどういう意味ですか?

自動音声認識 (ASR) 技術は、機械とソフトウェアを使用して、話し言葉を識別および処理します。 また、音声によって個人の身元を認証するためにも使用できます。 この技術は近年著しく進歩していますが、常に完璧な結果が得られるわけではありません。

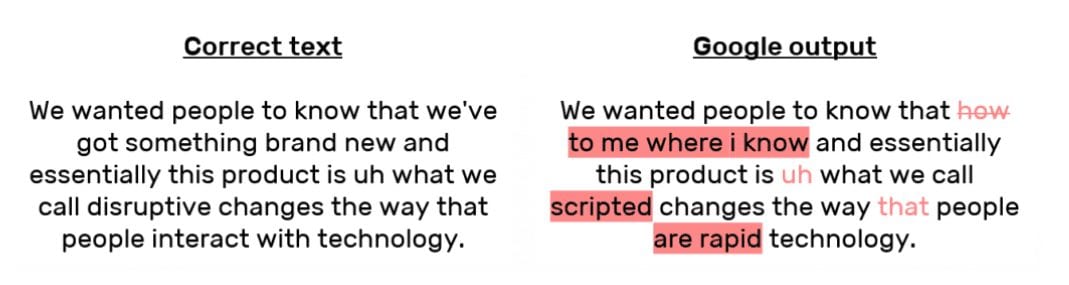

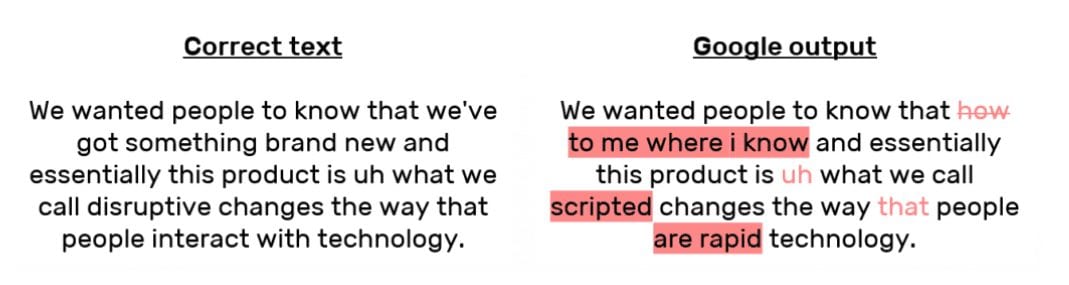

音声を認識してテキスト形式に変換する過程で、一部の単語が省略されたり、誤訳されたりすることがあります。 ASRを何らかの形で使用したことがある方なら、「ワードエラーレート(WER)」という言葉に出会ったことがあるのではないでしょうか。

WER の考え方、計算方法、およびなぜそれが重要なのかを説明します。

基本的な単語エラー率はどのように計算するのですか。

一見複雑そうに見えますが、基本の WER 計算方法は非常にシンプルです。 基本的に、WER はエラーの数を総語数で割ったものです。

WERを求めるには、まず、認識した一連の単語の中で発生した置換、挿入、および削除を合計します。 その数を元々話されていた単語の総数で割る。 その結果がWERです。

簡単な式にすると、Word Error Rate = (Substitutions + Insertions + Deletions) / Number of Words Spoken

しかし、これらの要素をどのように足し合わせるのでしょうか。 ひとつひとつ見ていこう。

- 置換は、ある単語が置き換えられるときに起こります(たとえば、「noose」は「moose」と転写されます)

- 挿入は、言われていない単語が追加されるときです(たとえば、「noose」は「moose」です。 “SAT” は “essay tea” になります)

- 削除は、ある単語が完全に転写から除外されたときに起こります(たとえば、”turn it around” は “turn around” になります)

例えば、ある人がオリジナルの転写ファイルで合計29語を話したとしましょう。 その中で、11個の置換、挿入、および削除が含まれています。

そのトランスクリプションの WER を得るには、11 を 29 で割って 0.379 とします。 これは四捨五入して 0.38 となり、WER は 38% です。

Word Error Rate の計算はどこから来たのでしょうか。

WERの計算は、”レーベンシュタイン距離 “と呼ばれる測定値に基づいています。 レーベンシュタイン距離とは、2つの “文字列 “の差を測定するものです。 この場合、文字列とは、転写の単語を構成する文字のシーケンスです。

先ほど使用したエラーの例を見てみましょう。 “noose” と “moose” です。 1文字しか変わっていないのでレーベンシュタイン距離は1しかありませんが、「SAT」と「essay tea」では、転写の際に「SA」は3を加えて「essay」に、「T」は2を加えて「tea」になるので、レーベンシュタイン距離は4倍以上になります<5280><3506>なぜ単語の誤り率が問題になるのでしょう?

WER は、Siri や Amazon Echo などの対話型音声ベースのテクノロジに使用されている音声認識 API のパフォーマンスを測定するために使用される、重要で一般的なメトリックです。 ASR テクノロジーを使用する科学者、開発者、およびその他の人々は、特定の目的のために製品を選択するときに WER を考慮することがあります。

WER は消費者レベルでも使用でき、自動トランスクリプション サービスや ASR アプリを選択する際に役立ちます。

WER は精度を測定する良い方法ですか。 しかし、サービスやソフトウェアの精度を決定する際に使用すべき唯一の要因ではありません。 5280>

Source of errors

WER は、エラーが発生する理由を説明するものではありません。 必ずしも ASR テクノロジー自体の能力を反映するわけではありませんが、WER に影響を与える要因としては、以下のようなものがあります。

- 録音品質

- マイク品質

- 話者の発音

- バックグラウンドノイズ

- 通常とは異なる名前、場所、および、そのような名前に対応するために使用されないもの。 その他の固有名詞

- 技術的または業界特有の用語

人間の解釈

ASRソフトウェアの使用方法によっては、エラーがユーザビリティに大きな影響を与えない場合もあります。 人間のユーザーがエラーだらけのトランスクリプトを読んで、それでも話し手の元の意味を理解できるなら、WER が高くても ASR の有用性を妨げることはありません。

Word エラー率は音声認識技術を使用する際に行う重要な計算ですが、他の要因や文脈を考慮することが重要です。

Rev はどのように評価されるのか?

Rev.ai API の WER を計算し、他の ASR オプションと比較するために、いくつかの人気のある Podcast から30の代表的なエピソードを選びました。 まず、Rev.com を使用して、人間が生成した逐語的な参照トランスクリプトを作成しました。 次に、それぞれの音声ファイルをRev.ai、Googleのビデオモデル、Speechmaticsに通し、ASRトランスクリプトを作成しました。 その後、ASRトランスクリプトの各単語を参照トランスクリプトと比較して、WERを求めました。

- Rev.ai: 16.6%

- Google Video model: 18.0%

- Speechmatics: 20.6%

具体的な結果はポッドキャストのエピソードによって異なりますが、Rev の自動音声認識 API がこの課題に対応していることは喜ばしいことです。

WER や Rev の音声テキスト API、または Rev.com の人間の転写サービスに関してご質問があれば、いつでもお気軽に弊社までお問い合わせください。 また、自動トランスクリプション サービスも簡単に始めることができます。